Uno de los puntos de fricción más comunes en un proyecto de ML es poseer un conjunto de datos que nos permita entrenar al proyecto, en algunos casos los datos no recogen todos los casos que queremos en nuestro modelo, por ejemplo, los relacionados con la generación de piezas malas. El proyecto, SEGULA busca generar datos sintéticos, es decir, a raíz de una pequeña masa de muestras, conseguir más datos y, de esa manera, conseguir que el modelo se ajuste lo más posible a la realidad.

Según Jorge Martínez Santiago, R&I Manager of the IA & Industry 4.0 de SEGULA en la oficina de Vitoria-Gasteiz, “cuando se quiere desarrollar un modelo de inteligencia artificial en proyectos industriales, por ejemplo, el objetivo puede ser detectar piezas defectuosas, que suelen representar un porcentaje muy bajo del total, en torno al 2%. La clave está en generar datos que se asemejen lo máximo posible a la realidad, para que el modelo pueda entrenarse adecuadamente. Ese modelo deberá cumplir una función específica, como mejorar la eficiencia energética o reducir los tiempos de producción. Lo habitual es que se generen datos, pero a menudo no se tiene la certeza de si estos reflejan fielmente la realidad”.

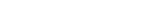

Durante el MESIC, Manufacturing Engineering Society International Conference, SEGULA ha presentado un paper relacionado con el proyecto: “Enhancing Industrial Model Performance Through Synthetic Data Generation Using Large Language Models: A Comprehensive Study on Methods, Fine-tuning, and Expert Knowledge Integration”.

Este estudio propone una forma novedosa de mejorar los conjuntos de datos sintéticos generados por modelos de lenguaje (LLMs), enriqueciéndolos con información adicional proveniente de procesos industriales similares y del conocimiento de expertos sobre la relación entre variables. El objetivo es mejorar el rendimiento de los modelos al incorporar esta información complementaria, superando las limitaciones habituales de los datos tradicionales.

Se evalúa sistemáticamente el impacto de estas mejoras mediante experimentos que abordan preguntas clave. Se comparan distintos LLMs en cuanto a su capacidad para generar datos sintéticos enriquecidos, y se analizan diferentes técnicas de fine-tuning para incorporar conocimiento externo de forma efectiva.

El proyecto ha logrado los objetivos planteados con unos datos que, a nivel experimental, se aproximan un 90% a los datos reales. No obstante, es necesario continuar con el estudio del uso de este tipo de datos en los modelos de ML en producción.

Durante el desarrollo del proyecto se han identificado diversos retos. Uno de los principales está relacionado con el tamaño de los datasets: a medida que estos crecen, también lo hace la demanda de capacidad de cómputo. Al aumentar el número de variables, la complejidad del hardware necesario se incrementa considerablemente. Por otra parte, aun es necesario poseer una cantidad significativa de datos de partida.

Otro desafío clave está vinculado a la cantidad de variables y a la dependencia existente entre ellas. Cuanto más complejo es el sistema, más difícil resulta predecir su comportamiento. Por este motivo, actualmente se está trabajando con sistemas de baja complejidad, que no superen las 100 variables. En definitiva, “si queremos hacer sistemas muy complejos con muchas variables y con una dependencia entre las variables muy alta, se complica mucho el modelo”, en palabras de Jorge Martínez.

PARA MEJORAR LA NAVEGACIÒN

PARA MEJORAR LA NAVEGACIÒN